"Ваша машина должна сбить этого ребенка". О беспилотных автомобилях и этике будущего

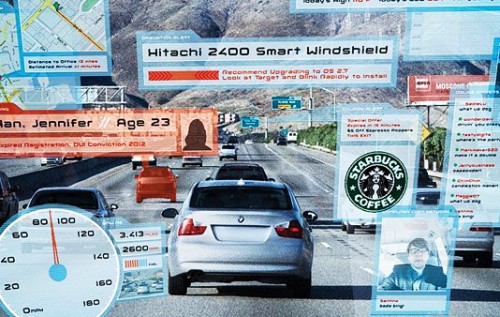

В сентябре 2016 года компания Uber запустила первые беспилотные такси в тестовом режиме, в декабре 2016 года компания Apple подтвердила, что приступает к разработке беспилотных машин, к 2020 году Google и Toyota планируют выпустить беспилотники на рынок, а, по данным отчета Business Insider, к 2020 году на дорогах будет 10 млн беспилотных машин. Развитие современных технологий и робототехники порождает все больше новых этических вопросов, которые пытаются разрешить специалисты этики роботов, новой ветви философии. Имеют ли право роботы на суицид и отказ от секса с человеком? Можно ли роботу ухаживать за стариками? В цикле бесед ведущие международные киберфилософы рассказали «Снобу» о вопросах, над которыми они ломают голову.

Джейсон Миллар , профессор Карлтонского университета (Оттава, Канада), сотрудничает со Стэнфордским университетом в исследовательском проекте «Этическое программирование беспилотных машин»:

Сейчас этика роботов - академическая дисциплина, прикладная область в философии. Мы ей занимаемся примерно как и на Западе философы занимаются биоэтикой. Эти вопросы все очень свежие: первая книга со сборником научных эссе на тему роботов и этики вышла только в 2012 году, ее автор Патрик Лин. Мы с ним вплотную работаем над философскими вопросами, которые касаются беспилотных машин. У нас такая традиция, что философы специализируются на практических вопросах, например, в сфере здравоохранения. И мы садимся и обсуждаем этические вопросы здравоохранения - аборты, эвтаназия. А теперь появилась прикладная дисциплина «Этика роботов» - и мы обсуждаем все вопросы, которые возникают по мере того, как развиваются роботы и искусственный интеллект.

Сейчас Uber запустили первые беспилотные машины, и сразу же возникли вопросы. Кому принадлежит машина, кто ответственен за решения, которые она принимает, можно ли будет купить машину подороже, чтобы она сильнее разгонялась, даже создавая опасность другим пассажирам на дороге? Вот это те вопросы, которыми мы занимаемся. Думаю, в ближайшие 10-15 лет американцы пересядут на беспилотные машины - технологии разрабатываются очень быстро. Uber уже и сейчас катает людей на таких, но у них все-таки за рулем пока еще сидит инженер на случай сбоев в системе.

Читайте также: 14 главных научных событий года

Мы с Патриком регулярно устраиваем мозговой штурм. Придумываем всевозможные ситуации на дороге. Я, бывает, могу придумать и по 100 ситуаций за час. Это удивительно, сколько там мелочей, с которыми придется столкнуться производителям машин. Например, едет машина по дороге, перед ней грузовик. Внезапно из грузовика высыпались коробки, в правой полосе едет мотоциклист со шлемом, а в левой полосе едет мотоциклист без шлема. Если машина поедет прямо, она врежется в коробки. Если направо и заденет мотоциклиста со шлемом, то у него больше шансов остаться в живых, чем если она поедет налево и собьет мотоциклиста без шлема. Но если программировать машины сбить мотоциклиста со шлемом, не будет ли это продвигать безответственное поведение мотоциклистов на дороге?

Все философские вопросы здесь связаны с рисками, которые берет на себя машина, а также с тем, кто должен быть ответственным за выбранную в машине программу езды - пассажир или производитель машины. Вот, например, ситуация. Пассажир все время нажимает кнопку «обгон», потому что спешит. А при очередном обгоне в машине случится сбой в алгоритме, и произойдет авария. Кто ответственен за эту аварию? Пассажир за то, что поставил машину в такой режим? Производитель за то, что недоглядел программирование?

Раньше вся ответственность за аварии ложилась целиком на водителя. Решение принимал только он сам. Происходит аварийная ситуация, и водитель за доли секунд должен принять решение. А теперь, когда такие решения должны быть заранее запрограммированы, философы сидят в кабинетах и представляют все возможные ситуации и спорят: как же запрограммировать машину на такой случай?

При этом, понятное дело, производители машин, конечно, не хотят брать на себя всю ответственность за все аварии - они же потом из судов не выйдут. И вопрос для философов - как нам равномерно разложить ответственность на всех участников дорожного движения. И все эти комплексные вопросы возникают ровно в тот момент, когда вы отнимаете у водителя руль. Раньше было проще.

Сейчас мы с Патриком работаем со Стэнфордом в проекте, который называется «Этическое программирование беспилотных машин». В Стэнфорде молодцы, они очень много делают программ по этике. Сами производители пока не спешат нанимать философов на работу. Но им все равно придется в скором будущем это сделать: в Департаменте транспорта в США два месяца назад выпустили методические рекомендации, где говорится, что перед тем, как выпускать беспилотную машину на рынок, производитель должен доказать, что продумал все этические вопросы до мелочей. Эти рекомендации вступают в силу в 2017 году, и думаю, что тогда производители обратятся к нам за советами. Но пока что эта область совершенно новая, и никто толком не понимает, что происходит. В этой индустрии нет никаких прописанных стандартов. Сейчас очень интересное время, чтобы заниматься такими проблемами. Но пока что производители не спешат обращаться к нам за помощью - они приходят иногда на наши конференции, послушают лекцию, а потом уходят. Но совсем скоро ситуация поменяется.

Вот еще одна дорожная проблема. Вы едете по двухсторонней дороге. Ее разделяет двойная сплошная - значит, по закону пересекать ее нельзя. Но иногда случается так, что кто-то припарковал машину там, где не должен был. Такое случается с каждым. И у вас тогда пара опций - вы можете либо чуть заехать на двойную сплошную и объехать припаркованную машину. Или вы должны просто встать за машиной и ждать, когда вернется водитель. Представьте реакцию машин сзади вас, если вы просто остановитесь и будете ждать, ждать, ждать. Согласитесь, чаще всего мы просто заезжаем за двойную сплошную - и проблема решена. Но если вы компания-производитель беспилотных машин, то вам необходимо запрограммировать машину так, что она нарушает закон, пересекая двойную сплошную. И это интересный вопрос: можно ли программировать машины, чтобы они нарушали закон?

Или еще вопрос - выбегает ребенок на дорогу. Вы хотите объехать ребенка, но по встречной полосе мчится грузовик. Если вы спасете ребенка, то въедете в грузовик и если не умрете, то уж точно сильно пострадаете. То есть вы спасете ребенка ценой собственной жизни. И если говорить начистоту, вообще-то этот ребенок не должен был играть на дороге. Поэтому по закону вы совсем не обязаны объезжать этого ребенка. Но одно дело - закон, а другое - возможная внутренняя необходимость пожертвовать собой ради ребенка. И это поднимает интересные вопросы. Как вообще должны выстраиваться теперь отношения всех участников движения: и пассажиров, и пешеходов. Нужно ли программировать машины так, чтобы они в первую очередь думали о жизни пассажиров или пешеходов? Или, может, запрограммировать ее так, чтобы они распределяли травмы на всех: например, ребенок выбежал на дорогу, и вы резко тормозите, и ребенка все-таки сбиваете, но не на смерть, только ноги ему переломаете. Зато все живы. Это ужасно - представлять все эти ситуации, но они требуют какого-то решения.

Притом что, как и свойственно философии, мы задаем много вопросов, но почти никогда не приходим к ответу. Даже мы с Патриком не можем прийти к единому решению по каким-то из этих вопросов.

Читайте также: Как научная фантастика воплощается в жизнь

Например, Патрик считает, что все этические вопросы должен брать на себя производитель машины. Он считает, что неправильно заставлять пассажира в машине выбирать программу - между своей жизнью и жизнью ребенка на дороге. Патрику кажется, что это все-таки вопрос к производителям, как бы им не хотелось снять эту ответственность с себя. Я же считаю по-другому. Не надо заставлять производителя брать ответственность на себя. Они должны только сообщать покупателю программные настройки машины, чтобы он заранее знал, какие решения эта машина будет принимать. Может ли быть в ближайшем будущем, что слоган одного производителя будет: «Садитесь в мою машину и всегда будете живы», а другого: «Садитесь в наши машины и ни одна белка не пострадает»? Да, я думаю, в обозримом будущем что-то такое и будет. Я считаю, что каждый человек сам должен решать, какой тип программы ему больше по душе. И лучше это делать «на берегу». Потому что, как только пассажир забирается в машину, после этого он уже сам себе не хозяин - с этого момента все решения по его безопасности принимает программа.

Александр Мишура, преподаватель школы философии факультета гуманитарных наук НИУ ВШЭ:

По беспилотным машинам у меня такая позиция. Ущерб должен нести тот, кто нарушает правила дорожного движения. Допустим, вы едете в автопилотируемой машине и перед вами на дорогу выбегает ребенок. Автопилотируемая машина может резко свернуть в сторону, попытавшись избежать столкновения с ребенком, но в таком случае вы сами рискуете получить серьезные травмы, столкнувшись с кем-либо на встречной полосе. Я полагаю, что в данной ситуации машина должна быть запрограммирована сбивать нарушителя правил дорожного движения, в нашем примере - ребенка. Суть правил дорожного движения - создание предсказуемости на дорогах. Если автопилотируемые машины будут оберегать нарушителей правил во вред тем, кто эти правила соблюдает, сами правила утратят смысл. С другой стороны, возникает вопрос о том, насколько этично лишать человека выбора, в данном случае - сбивать ребенка или самому пострадать. На это, однако, можно ответить, что в соответствующей ситуации для выбора практически не остается времени. Кроме того, если родитель будет знать, что любой ребенок, который выбегает на дорогу, имеет реальные риски быть сбитым, он будет внимательнее и сто раз скажет ребенку о недопустимости перехода дороги в неположенном месте. Если же мы будем понимать, что какие-то водители ставят машину в режим «спасение детей», то и родители будут надеяться на авось, что ребенка минует опасность.

Читайте также: Китай показал самый большой в мире боевой дрон. ФОТО

Повідомити про помилку - Виділіть орфографічну помилку мишею і натисніть Ctrl + Enter

Сподобався матеріал? Сміливо поділися

ним в соцмережах через ці кнопки